Deep Learning

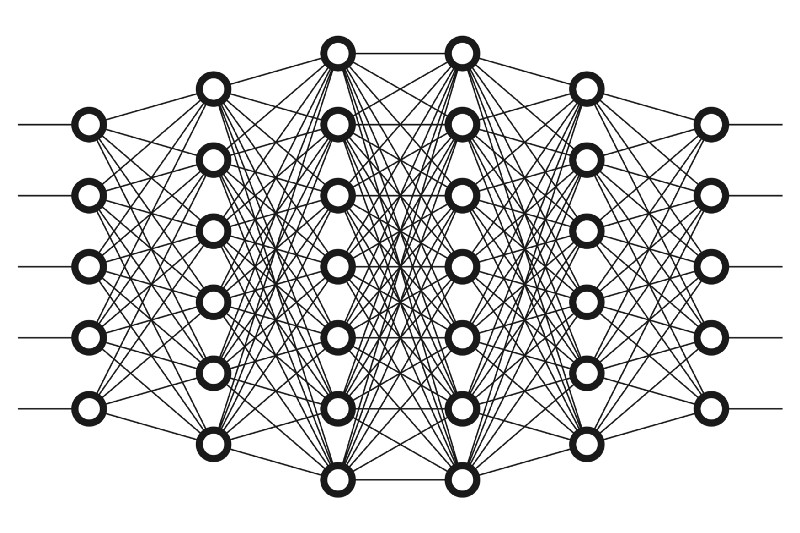

El Deep Learning, o aprendizaje profundo, es una subcategoría del Machine Learning. Se basa en la utilización de redes neuronales artificiales con múltiples capas para aprender y extraer características de los datos.

El Deep Learning se utiliza en diversas aplicaciones, como la visión artificial, el procesamiento del lenguaje natural (NLP), la traducción automática, la detección de fraude, la identificación de objetos, entre otras. Debido a su capacidad para aprender de forma autónoma y su alta precisión en la identificación de patrones complejos en los datos, el Deep Learning se ha convertido en una técnica clave al origen de los últimos avances de la IA.

Cómo funciona el Deep Learning

Las redes neuronales utilizadas en el Deep Learning intentan emular el comportamiento del cerebro humano, permitiendo a los sistemas «aprender» a partir de grandes cantidades de datos. Se componen de múltiples capas de neuronas interconectadas, cada una de las cuales procesa una parte de los datos. Las características extraídas se utilizan en las capas posteriores para extraer características más complejas. Este proceso se repite en cada capa hasta que se extraen las características más abstractas del conjunto de datos.

El término «profundo» en Deep Learning se refiere al uso de múltiples capas en la red. Aunque una red neuronal con una sola capa ya puede realizar predicciones aproximadas, las capas ocultas adicionales ayudan a optimizar y refinar la precisión.

Durante la fase de entrenamiento, el aprendizaje se logra mediante un proceso llamado «propagación hacia atrás» (back propagation), donde el modelo ajusta sus parámetros internos —los pesos y sesgos de las neuronas— para minimizar el error en sus predicciones. Cada neurona en la red tiene un peso que influye en la fuerza de la señal que pasa a través de ella y un sesgo que permite ajustar la salida.

El modelo hace una predicción, y luego se compara esta predicción con la respuesta correcta para calcular el error. Este error se utiliza para realizar ajustes en los pesos de las neuronas, de manera que en la próxima iteración la predicción sea más precisa. Los ajustes se calculan utilizando un algoritmo de optimización, como el descenso del gradiente, que modifica los pesos en la dirección que reduce el error.

Este proceso se repite con muchos ejemplos de entrenamiento y miles, o millones de pases (epoch) en la red, consiguiendo ajustar así progresivamente las características y patrones que son relevantes para la tarea en cuestión.

Con el tiempo y tras numerosas iteraciones, la red neuronal «aprende» a realizar la tarea con una precisión cada vez mayor, ajustando sus parámetros internos para responder de manera efectiva a datos que nunca ha visto antes. Este proceso es lo que hace que el Deep Learning sea particularmente poderoso para tareas que involucran grandes volúmenes de datos y para las que la programación de reglas explícitas sería impracticable o imposible.

Aplicaciones del Deep Learning en entorno de negocios

El Deep Learning está transformando múltiples industrias con su capacidad para extraer insights valiosos y automatizar tareas complejas. Aquí algunos de los principales usos del Deep Learning en el entorno empresarial:

- Reconocimiento de Imágenes: en el sector minorista, se utiliza para identificar productos y analizar el comportamiento de los clientes mediante el reconocimiento visual en tiendas físicas. También es clave en la inspección de calidad automatizada en manufactura (detección de fallos).

- Procesamiento del Lenguaje Natural (NLP): empresas de todos los sectores utilizan NLP para traducciones, análisis de sentimientos, y extracción de información de documentos legales y técnico.

- Predicción de Series Temporales: en finanzas, se emplea para predecir movimientos del mercado y en la cadena de suministro para la previsión de demanda y la optimización de inventarios.

- Reconocimiento de Voz y Asistentes Virtuales: utilizado por empresas de telecomunicaciones y tecnología para mejorar la interacción con el cliente y automatizar respuestas en centros de llamadas.

- Autenticación Biométrica: empresas de seguridad y servicios financieros usan reconocimiento facial o de huellas dactilares para la autenticación segura de usuarios.

- Vehículos Autónomos: en la logística y el transporte, el Deep Learning facilita el desarrollo de sistemas de conducción autónoma para mejorar la eficiencia y seguridad.

- Análisis Predictivo y Mantenimiento: en la industria pesada y la manufactura, se utiliza para predecir fallos en equipos y programar mantenimiento preventivo, lo que reduce los tiempos de inactividad y los costos operativos.

- Personalización y Recomendaciones: empresas de comercio electrónico y servicios de streaming utilizan algoritmos de Deep Learning para personalizar recomendaciones de productos y contenidos, mejorando la experiencia del usuario y aumentando las ventas.

- Análisis de Sentimientos en Redes Sociales: las marcas utilizan Deep Learning para monitorear y analizar opiniones y tendencias en redes sociales, lo que les permite gestionar la reputación de la marca y adaptar estrategias de marketing.

- Detección de Fraude: en el sector financiero, se emplea para detectar patrones sospechosos y prevenir fraudes en transacciones en tiempo real.

Principales técnicas de Deep Learning

En el ámbito del Deep Learning, varias técnicas de redes neuronales han sido desarrolladas para diferentes tipos de tareas. Aquí hay una descripción de algunas de las técnicas más importantes:

- Autoencoders: los autoencoders son modelos de Deep Learning que capturan la esencia de los datos. Están diseñados para comprimir la información de entrada en una representación más pequeña y luego reconstruirla con la mayor fidelidad posible. Esta capacidad los hace ideales para la reducción de la dimensionalidad y la detección de anomalías en conjuntos de datos complejos.

- Modelos Autoregresivos: en el contexto del Deep Learning, los modelos autoregresivos aprenden a predecir futuras entradas de una secuencia basándose en observaciones anteriores. Son cruciales en análisis de series temporales y pueden ser utilizados para predecir precios de acciones, patrones meteorológicos y tendencias de mercado.

- Modelos Secuencia a Secuencia: Estos modelos transforman secuencias de entrada en secuencias de salida, siendo fundamentales en tareas como la traducción automática. Funcionan codificando una secuencia de entrada en un estado latente y luego decodificando ese estado en una nueva secuencia.

- Redes Neuronales Convolucionales (CNNs): las CNNs son especialistas en entender imágenes, aplicando filtros que detectan características visuales a distintos niveles de abstracción, lo que les permite realizar tareas de reconocimiento de imágenes y detección de objetos con gran precisión.

- Redes Neuronales Recurrentes (RNNs): son modelos que se destacan en el manejo de datos secuenciales, como el lenguaje hablado o escrito. Las RNNs pueden utilizar su memoria interna para procesar secuencias de información, lo que las hace adecuadas para el reconocimiento de voz y la generación de texto.

- Redes de Memoria a Largo Corto Plazo (LSTMs): una mejora de las RNNs, las LSTMs están diseñadas para recordar información por periodos prolongados y son muy eficaces en tareas que requieren comprender contextos complejos en los datos de entrada.

- Redes Generativas Adversarias (GANs): las GANs consisten en dos redes, una generadora y otra discriminadora, que se entrenan en conjunto. La red generadora crea datos que la discriminadora intenta clasificar como reales o falsos, lo que resulta en la generación de imágenes realistas y otros tipos de datos.

- Transformers: los modelos de transformers han revolucionado el NLP con su capacidad para manejar secuencias de datos. Utilizan mecanismos de atención que les permiten considerar el contexto completo de los datos de entrada, lo que mejora la comprensión y la generación del lenguaje.

- Vision Transformers (ViTs): una innovación reciente que aplica la arquitectura de los transformers, conocidos en el procesamiento del lenguaje, al análisis de imágenes. Los ViTs dividen imágenes en una secuencia de parches y las procesan utilizando mecanismos de auto-perfeatención para capturar relaciones contextuales entre ellos. Esta metodología permite a los ViTs aprender representaciones visuales potentes y complejas, haciéndolos particularmente efectivos en tareas de clasificación y comprensión de imágenes a gran escala.

Computer vision (visión artificial)

Las técnicas de Computer Vision, o visión artificial, son métodos que permiten a las máquinas adquirir, procesar, analizar y comprender imágenes digitales, y extraer información útil de ellas. Se utilizan en una amplia variedad de aplicaciones, como la automatización industrial, los vehículos autónomos, la medicina y el reconocimiento facial.

Algunas de las técnicas más avanzadas en este campo incluyen:

- Clasificación de imágenes: Permite a las máquinas ver una imagen y clasificar a qué clase pertenece.

- Detección de objetos: Consiste en identificar y localizar objetos específicos en una imagen.

- Segmentación semántica: Permite dividir una imagen en regiones y asignar a cada región una etiqueta semántica.

- Segmentación de instancias: Similar a la segmentación semántica, pero distingue entre diferentes instancias de la misma clase.

existen diferentes tipos de redes neuronales utilizadas en visión artificial, cada una con arquitecturas y aplicaciones especializadas. Las más habituales son las Redes Neuronales Convolucionales (CNN), las Redes Neuronales Recurrentes (RNN) y los Vision Transformers más recientemente.

Procesamiento de lenguaje natural (NLP)

El Procesamiento del Lenguaje Natural (NLP, por sus siglas en inglés) es una rama de la inteligencia artificial que permite a las computadoras entender, interpretar y manipular el lenguaje humano. Utiliza modelos de lingüística computacional, machine learning y aprendizaje profundo para procesar el lenguaje humano en forma de datos de texto o voz y «comprender» su significado completo, junto con la intención y el sentimiento del orador o escritor.

Algunas de las aplicaciones más comunes de NLP incluyen la traducción de idiomas, la generación de texto, el análisis de sentimientos, la extracción de información y la respuesta a preguntas. El NLP se utiliza en una amplia variedad de campos, incluyendo la medicina, el comercio electrónico, la atención al cliente, la seguridad y el entretenimiento.

Los modelos de transformers, como BERT y GPT-3, han significado un gran avance en el NLP en los últimos años. Estos modelos utilizan mecanismos de atención y grandes volúmenes de datos para aprender a predecir y generar lenguaje con un contexto más amplio y preciso. Su capacidad para ajustarse a tareas específicas, incluso con cantidades relativamente pequeñas de datos etiquetados, ha mejorado de manera significante la eficiencia y la eficacia de las aplicaciones basadas en NLP.

Limitaciones y desafíos del Deep Learning

El Deep Learning ha logrado avances significativos en campos como el reconocimiento de voz e imagen, la traducción automática y la generación de texto, entre otros. No obstante, su uso no está exento de varios desafíos:

- Necesidad de Grandes Cantidades de Datos: Los modelos de Deep Learning generalmente requieren enormes conjuntos de datos para entrenamiento, lo que puede ser un obstáculo si los datos son escasos o costosos de obtener.

- Costo Computacional: Entrenar redes neuronales profundas es intensivo en recursos computacionales, lo que puede implicar altos costos de infraestructura y energía, y su impacto medioambiental.

- Sobreajuste (Overfitting): Hay un riesgo de que los modelos se ajusten demasiado a los datos de entrenamiento y, por lo tanto, no generalicen bien a nuevos datos.

- Interpretabilidad y Explicabilidad: Los modelos de Deep Learning son a menudo considerados «cajas negras» porque sus procesos de decisión internos no son fácilmente interpretables por los humanos.

- Dependencia de Características: La calidad del aprendizaje depende en gran medida de la representación de los datos de entrada, lo que puede requerir una ingeniería de características sofisticada y especializada.

- Sesgo: Los modelos pueden perpetuar o incluso exacerbar los sesgos presentes en los datos de entrenamiento, llevando a respuestas injustas o poco éticas.

- Seguridad y Vulnerabilidad: Los modelos de Deep Learning pueden ser susceptibles a ataques adversarios, donde pequeñas alteraciones en los datos de entrada pueden causar grandes errores en las salidas.

- Problemas de Privacidad: La recopilación y el uso de grandes cantidades de datos personales para entrenar modelos pueden plantear problemas de privacidad y cumplimiento normativo.